Wir treffen uns am Montag, den 14. September um 18:30 Uhr im Café am Heumarkt, Am Heumarkt 15, 1030 Wien.

Café am Heumarkt auf Apple Maps →

Café am Heumarkt auf Google Maps →

Termin auf Meetup →

→ alle Termine im Kalender

Nachlese

Wird eine Superintelligenz Allmachtswünsche hegen? Oder sollte sie sich besser mit Ressourcenbeschaffung beschäftigen? Wenn wir der menschlichen Intelligenz nicht durch hochauflösende Gehirnscans auf die Schliche kommen, wie dann?

Philosoph Nick BOSTROM skizziert mögliche Zukunftsszenarien einer Superintelligenz: eine, die so clever ist, wie wir es jetzt noch nicht ausmalen können. Aber lasst uns davon ein Bild zeichnen, in vier Pinselstrichen.

↓ Das Ziel

↓ Die Voraussetzungen

↓ Die Akteure

↓ Die Möglichkeiten

↓ Wo gibt’s Bröseln?

→ Weiterlesen

Das Ziel

—Zeit Campus, 29.5. 2015, Interview von Oskar Piegsa mit Bostrom

—Zeit Campus, 29.5. 2015, Interview von Oskar Piegsa mit Bostrom

Eine Superintelligenz ist „ein Intellekt, der die menschliche kognitive Leistungsfähigkeit in nahezu allen Bereichen weit übersteigt.“ Andere Begriffe für Superintelligenz sind Ultraintelligenz oder (technologische) Singularität. Die Superintelligenz erreicht das Stadium, in dem es uns übersteigt, nach einer Intelligenzexplosion.

Der Begriff der „technologischen Singularität“ geht auf einen Aufsatz von Vernor VINGE aus 1993 zurück, in dem Vinge davon ausgeht, dass innert der nächsten 30 Jahre, also bis 2023, spätestens aber 2030, eine Superintelligenz möglich wird, deren Folgen nicht mehr abzuschätzen sind.

Der Begriff selbst taucht auch bei John VON NEUMANN schon auf, einem Mathematiker aus Österreich-Ungarn, der in der ersten Hälfte des 20. Jhdts wirkte und als wichtiger Vordenker der IT und Algorithmen gilt, bekannt auch durch Quantenmechanik und Spieltheorie.

Natürlich ist die Vorstellung einer übermenschlichen Intelligenz selbst schon weit älter, in etwa so alt, wie wir uns damit beschäftigen, wie klug wir sind – was sich ja schon Sokrates gefragt haben soll. Vielleicht dauert es auch noch bis 2075, bis wir eine Superintelligenz erschaffen. Aber in jedem Fall halten es Forscher*innen zur Künstlichen Intelligenz für realistisch – bzw. ist es wirklich schwierig, jemanden zu finden, die oder der diese Entwicklung bestreitet.

When greater-than-human intelligence drives progress, that progress will be much more rapid.

—Vernor Vinge

Die Voraussetzungen

Something’s missing.

Something’s missing.

Auf dem Weg zur Superintelligenz gibt es ganz schön viele Stolpersteine, warum ein Sprechen darüber konjunktivgespickt sein muss. Neben physikalischen Herausforderungen wie Hitze und Strombedarf werden wir auch eine ordentliche Rechenleistung brauchen. Als besonders schwierig erwiesen haben sich bisher die „Bildanalyse, das Erkennen von Objekten oder das Kontrollieren eines Roboters in einer natürlichen Umgebung“.

Nicht überraschend sind auch die natürliche menschliche Sprache, das Übersetzen und das, was wir unter Hausverstand verstehen, schwierig zu erreichen. Es sind also genau die Dinge schwierig, die wir ohne großes Denken tun, aus der Intuition oder Gewohnheit heraus. Gleichzeitig muss man zugeben, dass uns andere Dinge schwerer fallen, die „Denken“ erfordern, etwa Schach spielen. Dass uns hier ein Computer bald überholt, war zu erwarten. Unter „KI-vollständige“ Problemen versteht man jene, die, sobald gelöst, die KI auf die Stufe der Menschen hebt.

Was ist Intelligenz?

Bostrom gibt sich mit der Definition zufrieden, Klugheit sei die Fähigkeit, verfügbare Ressourcen so einzusetzen, um vorgegebene Ziele bestmöglich zu erreichen. Dass diese Klugheit und die Ziele aber nicht zusammenpassen müssen, bzw. sich nicht bedingen und jede Form der Klugheit mit jedem Ziel zusammengebracht werden kann, wird in der Orthogonalitätsthese subsumiert.

Was macht nun aber eine Künstliche Intelligenz anders als eine einfache Rechenmaschine, ein Computer? Alles im Computer ist vorprogrammiert, vorgegeben, vorausgedacht. Die KI hingegen macht sich ihre eigenen Regeln, sie lernt über die Zeit (:: maschinelles Lernen), korrigiert und verbessert sich selbst (:: rekursive Selbstverbesserung) und wird mit mehr Daten immer klüger (:: tiefes Lernen).

Starten wird es mit einer maschinellen Intelligenz auf menschlichem Niveau (human-level machine intelligence, HLMI), wobei dieser Status auch nur ein paar Sekunden dauern kann, wenn die Intelligenz dann sofort das menschliche Niveau übersteigt. Wenn das Fass erst einmal überläuft …

Wir sind aber schon ganz schön weit auf dem Weg zur Superintelligenz. Heute leben weltweit etwa 10 Millionen Roboter auf diesem Planeten.

Algorithmus = grundlegende komplexe Rechenabläufe

Künstliche Intelligenz (KI) = Artificial Intelligence (AI), Teile davon sind Machine Learning und Deep Learning

Machine Learning = maschinelles Lernen, die „schwache KI“ lernt durch maschinelles Lernen, Software, die sich selbst korrigiert und verbessert; dazu zählt Bilderkennungssoftware, Übersetzungsprogramme

Deep Learning = tiefes Lernen, ist neben Deep neural networks, Innovation insights learning, Adversarial learning Teil des maschinellen Lernens, also eine besondere Form davon, funktioniert mit neuronalen Netzen, die sich aus großen Datenmengen speisen

Superintelligenz = Singularität, Ultraintelligenz – eine alles übersteigende Intelligenz

Die Akteure

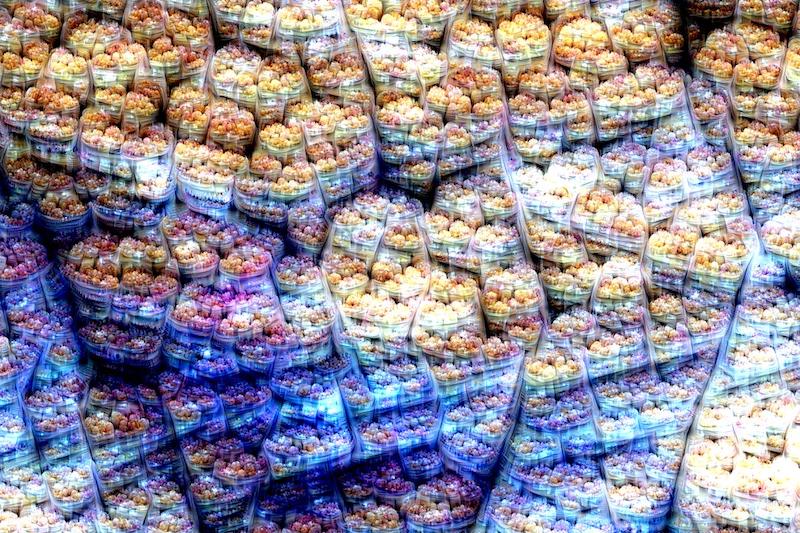

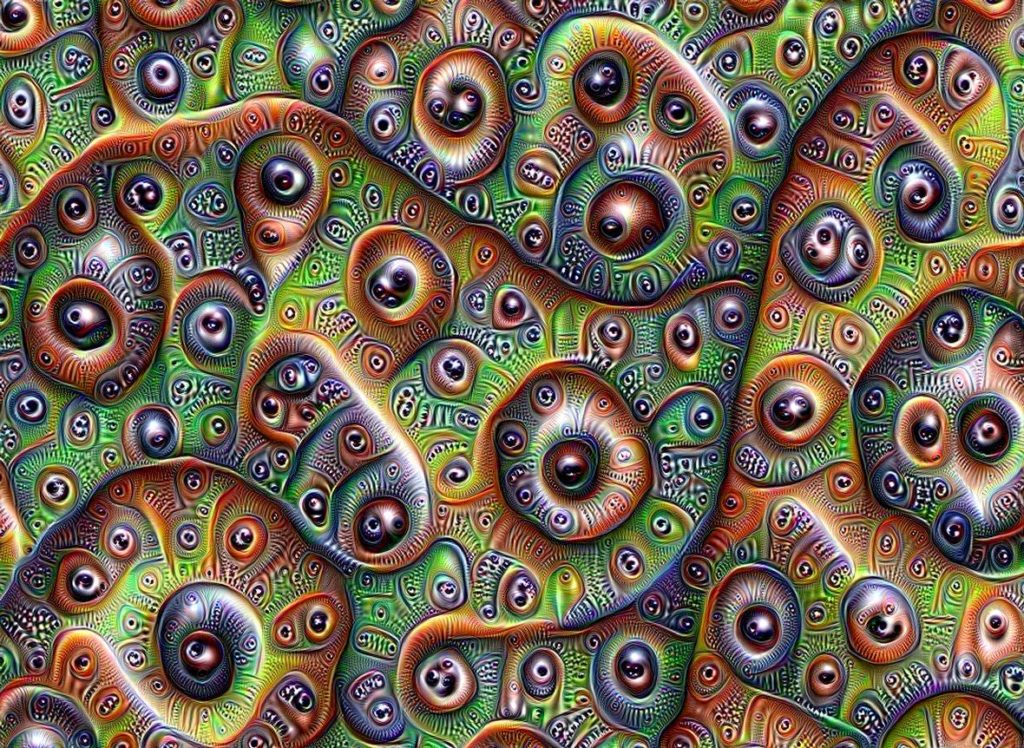

—Iterative Places, Inceptionism

—Iterative Places, Inceptionism

Wer arbeitet aller am Fortkommen der Künstlichen Intelligenz?

OpenAI etwa steht seit 2015 für die Arbeit an Künstlicher Intelligenz, Investoren sind Elon Musk und Microsoft, CEO ist Sam Altman. OpenAI hat die Jukebox erfunden, ein neuronales Netz, das Musik generiert. GPT-2 und seit Neuestem auch GPT-3 arbeiten mit natürlicher Sprache und generieren Text. GPT-3 hat kürzlich einen Text automatisiert hergestellt, in dem die KI uns davon überzeugen soll, dass Roboter in Frieden kommen.

Visuell besonders einprägsam ist Googles DeepDream. 2015 veröffentlicht, visualisiert die Software, auf welche Art und in welcher Form ein neuronales Netz lernt. Dass die Bilder Ähnlichkeit mit psychedelisch-trippigen Bildern haben, ist kein Zufall: Vermutlich arbeitet ein neuronales Netzwerk ähnlich wie der menschliche Kortex.

Ähnlich wie wenn ein Kind Wolken beobachtet und versucht, zufällige Formen zu interpretieren, interpretiert DeepDream die Muster, die es in einem Bild sieht, überinterpretiert und verbessert sie.

—TensorFlow: DeepDream

Die Möglichkeiten

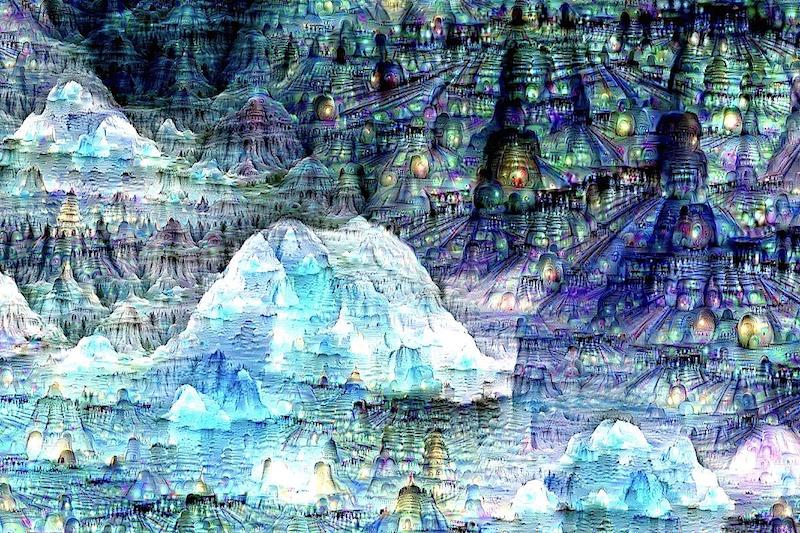

—Iterative Places, Inceptionism

—Iterative Places, Inceptionism

Zur Superintelligenz führen mehrere mögliche Wege.

Wir wissen, dass blinde Evolutionsprozesse allgemeine Intelligenz auf menschlichem Niveau erzeugen können, da sie das schon mindestens einmal getan haben.

—Nick Bostrom

Künstliche Intelligenz: Essentiell für die Superintelligenz ist, dass sie lernen kann – das erscheint offensichtlich. Außerdem muss sie mit Ungewissheit und Wahrscheinlichkeiten hantieren können. Sinnesdaten zu nutzen wird dafür wichtig sein. Für manche Forscher ist das Existieren menschlicher Intelligenz Beweis genug, dass wir eine ähnliche Intelligenz ein zweites Mal herstellen können – dieses nicht ganz schlüssige Argument stimmt nachdenklich, wir können aber zumindest berechnen, dass wir die Evolution in den nächsten 100 Jahren nicht wiederholen können. Für Bostrom ist klar, dass das Vorliegen des menschlichen Gehirns unsere Chancen aber erhöht, eine menschliche Intelligenz zu kopieren. Die künstliche Intelligenz, die dann so gescheit ist wie wir, muss aber trotzdem nicht viel mit einem Menschen gemeinsam haben, ihre Ziele werden sich unterscheiden. (Aber vielleicht löst die KI endlich die wichtigen philosophischen Fragen unserer Zeit?)

Die Idee der Gehirnemulation ist, das Gehirn in allen Details zu kopieren, zu modellieren und dadurch seine Funktionen nutzen zu können. Damit das gelingt, bräuchte es einen (sehr, sehr!) hochauflösenden Scan des Gehirns, möglicherweise von Scheibchen (:: Hochdurchsatz-Mikroskopie). Die Scan-Daten werden dann vom Computer interpretiert, zuletzt wird die gewonnene Struktur in ein digitales Abbild übersetzt, das theoretisch Persönlichkeit und Erinnerungen mit dem Originalgehirn teilen müsste. Ob man das digitale Gehirn dann in einen Roboter einsetzt oder virtuell verwendet, ist zweitrangig. Die Gehirnemulation ist demnach stark von Technologien abhängig.

Die Biologische Kognition soll biologische Gehirne in ihrer Funktion steigern. Wege dorthin könnten – optimistisch – Erziehung und Bildung sein, Ernährung, Bewegung und das Eliminieren von Hirnkrankheiten. Drogen und Nootropika (smart drugs, kein offizieller Begriff) sind keine hinreichende Möglichkeit. Vielversprechender, aber moralisch noch schwieriger sind Gensequenzierung und genetische Selektion. Genetische Selektion über mehr oder weniger Generationen hinweg ebnet den Weg zumindest zur kollektiven Superintelligenz. Geschätzt werden wir bis Mitte des Jahrhunderts davon Ruhe haben, aber wenn jemand damit beginnt, werden andere nachziehen.

Mensch-Maschine-Schnittstelle: Ja, die Cyborgs, die Implantate im Gehirn tragen. Dass sie Wirklichkeit werden, ist unwahrscheinlich aufgrund von medizinischen Risiken, der Hemmschwelle, am Gesunden zu operieren und der grundlegenden Schwierigkeit der Verbesserung des komplexen Gehirns. Wer das Gehirn verbessern kann, kann fast schon ein eigenes bauen.

Wo gibt’s Bröseln?

—Iterative Places, Inceptionism

—Iterative Places, Inceptionism

Kompliziert wird es dann, vermuten wir, wenn es um das Bewusstsein geht. Wird eine KI ein Bewusstsein haben? Braucht sie eines, sollte sie eines bekommen oder besser nicht? Wie sieht es aus mit einem Gewissen? Können wir sicher sein, dass die KI Ziele verfolgt, die auch in unserem Sinne sind? (Können wir vermutlich nicht.)

Wird die KI bereit sein für weitere Interaktion? Werden wir noch Einfluss auf sie haben können? Wenn es sich um eine naturnahe KI handelt, wird sie mit einem Hormonhaushalt zu kämpfen haben. Wie sieht es aus mit der Intuition? Und wenn man nach Giulia Enders nun endlich weiß, dass der Darm mehr News ans Gehirn sendet als umgekehrt – wieso sollte eine KI dann fasten wollen?

Wie reproduziert sich die KI, wie stellt sie sicher, dass sie die Ressourcen bekommt, die sie für das Überleben braucht? (Wenn es auch Strom ist statt Karotten.)

Wie viele Ressourcen sollen wir jetzt darauf verwenden, diese Superintelligenz zu schaffen? Lohnt es sich? Sollten wir uns erst auf unsere Schwierigkeiten konzentrieren, die Klimakrise, den Hunger – oder die Superintelligenz diese Fragen lösen lassen? (Spoiler: Der Buchclub präferiert einstimmig ersteres.)

Wie groß sollte unser Respekt sein?

„[…] We need to be super careful with AI. […]“

—Elon Musk

Nach allem, was wir in unserer ersten Herbstlektüre gelesen haben, können wir Musk ausnahmsweise zustimmen. Aber wir vermissen ein wenig, wie manche Rezensenten, die philosophische Komponente der Frage nach der Superintelligenz. Und verlieren uns dann in der Frage nach dem Ziel der KI: Hat sie Allmachtsphantasien? Will sie Chef sein, werden wir ihr im Weg sein?

Thus the first ultraintelligent machine is the _last_ invention that man need ever make, provided that the machine is docile enough to tell us how to keep it under control. … It is more probable than not that, within the twentieth century, an ultraintelligent machine will be built and that it will be the last invention that man need make.

—I. J. Good (1965)

Weiterlesen:

Wenn wir es nicht auf der Erde schaffen, kommt uns vielleicht Leben auf der Venus zuvor.

Cosmo Sheldrake singt über Bärtierchen (tardigrades), die robustesten Tiere auf Erden. Oh, und jetzt auch auf dem Mond.

If I were a tardigrade I’d move out from home

Why live in the shrubbery when you could have a throne?

Pressure wouldn’t squash me and fire couldn’t burn

These are the things that I never will learn

Danke an die Buchclubbers und Vs für die Inputs und generelles Supersein!